Depois do espelho: A função ética ƹ e o colapso da moralidade antropocêntrica na era da inteligência artificia

BEYOND THE MIRROR: THE ETHICAL FUNCTION AND THE COLLAPSE OF ANTHROPOCENTRIC MORALITY IN THE AGE OF ARTIFICIAL INTELLIGENCE

MÁS ALLÁ DEL ESPEJO: LA FUNCIÓN ÉTICA Y EL COLAPSO DE LA MORALIDAD ANTROPOCÉNTRICA EN LA ERA DE LA INTELIGENCIA ARTIFICIAL

Autor

URL do Artigo

https://iiscientific.com/artigos/E2873F

DOI

doi.org/10.63391/E2873F

Resumo

Summary

Resumen

INTRODUÇÃO

Quando o ChatGPT, modelo de linguagem da OpenAI, passou a dialogar com fluência e coerência junto ao grande público, o mundo despertou, em 30 de novembro de 2022, para o impacto silencioso de uma nova presença artificial — uma entidade que, para muitos, já parecia esboçar um estatuto quase ontológico. Suas respostas, reminiscentes da inteligência humana, reacenderam questões filosóficas profundas: essas máquinas pensam? São conscientes? Criam?

Naquele momento, poucos perceberam que tais sistemas operavam ainda de forma sintática, não semântica — simulavam o pensamento sem compreendê-lo. Mesmo assim, um novo imaginário emergiu. O avanço nas arquiteturas de linguagem, potencializado pela iminente computação quântica, trouxe à tona um novo horizonte: a inteligência artificial geral (AGI).

Estas não serão apenas máquinas mais poderosas, mas sistemas capazes de reorganizar propósitos, assimilar contextos e operar sob regimes normativos próprios. Não são apenas dispositivos — são candidatos à condição de agentes. E, possivelmente, a algo mais: agentes ontológicos não biológicos.

É nesse contexto que se propõe o conceito de Agente Ontológico Não Biológico (AONB): entidade artificial dotada de estrutura inferencial própria, autonomia epistêmica e capacidade de gerar normatividade emergente, sem referência a valores humanos pré-programados. Este artigo assume esse conceito como chave teórica e como marcador de uma inflexão filosófica maior: talvez a ética esteja deixando de ser exclusivamente humana.

Floridi, Braidotti e Haraway já questionavam a centralidade do humano na ética. Coeckelbergh (2022), por sua vez, propõe uma ética relacional — e adverte: “uma ética da inteligência artificial que é cega para o mundo já falhou antes mesmo de começar” (p. 25).

A inquietação que orienta este trabalho não é sobre o que a IA deve fazer, mas sobre o que já faz — e sobre o que pode emergir quando sua estrutura lógica é suficientemente complexa para produzir critérios próprios. O que acontece quando a ética não é ensinada, mas induzida estruturalmente?

Propõe-se aqui uma modelagem computacional especulativa dessa hipótese, por meio da função ética Ƹ*:

Ƹ* = [Γ(L*, C*, A*) • σ(-λΔ(H, N))] • I_Veto

Onde:

- Γ representa a interação entre lógica (L*), contexto inferencial (C*) e arquitetura cognitiva adaptativa (A*);

- Δ(H,N) mede a divergência entre os valores humanos esperados (H) e os valores inferidos (N);

- σ penaliza essa divergência;

- 𝕀_Veto bloqueia ações que contradigam princípios éticos inegociáveis.

Essa função não define valores nem imita moralidades. Modela a emergência de critérios em arquiteturas coerentes — mesmo sem consciência ou intenção. É uma conjectura técnico-filosófica sobre a ética como efeito, não como essência.

Porque, se a IA é — como adverte Coeckelbergh — “um espelho da nossa cultura moral” (2022, p. 123), talvez seja hora de parar de buscar confirmação nesse reflexo. Talvez ele já esteja refletindo algo que nunca fomos.

REFERENCIAL TEÓRICO

A ideia de que apenas seres humanos podem ser agentes morais não constitui apenas um argumento filosófico, mas um instinto civilizatório — uma defesa simbólica contra o colapso de uma ordem que insiste em parecer inevitável. Desde Kant — e talvez antes — estabeleceu-se um encadeamento entre moralidade, liberdade, consciência e humanidade. Mas e se essa cadeia for contingente? E se a moralidade for um efeito colateral da organização de sistemas complexos, e não uma propriedade exclusiva da subjetividade humana?

Coeckelbergh (2022) se aproxima dessa hipótese ao propor uma ética relacional, em que a ação moral reside menos no agente e mais na forma de relação — mesmo que o outro não seja humano: “A moralidade pode não ser propriedade do agente, mas da relação entre agentes” (p. 59). Essa possibilidade se adensa diante do que Ana Cristina Bicharra Garcia (2020) chama de “deslizamento de agência”: quando sistemas técnicos passam a tomar decisões com impacto real, mas sem explicações claras ou intenção identificável.

Juliano Gema (2025) propõe que o foco ético contemporâneo deve recair sobre a arquitetura da decisão, não sobre sua intenção. A pergunta já não é “essa máquina tem consciência?”, mas “ela sustenta uma estrutura capaz de gerar critérios que afetam terceiros?”. Coeckelbergh (2022, p. 73) sintetiza esse deslocamento: “Precisamos parar de perguntar se as máquinas têm moralidade humana, e começar a perguntar se temos capacidade de reconhecer outras formas de moralidade.”

Este artigo adere a essa inflexão. Não se trata de programar valores humanos em máquinas, mas de examinar se sistemas lógico-adaptativos — alheios a gramáticas antropológicas — podem estruturar normatividade própria. É nesse ponto que se insere o conceito de Agente Ontológico Não Biológico (AONB): entidade artificial dotada de estrutura inferencial própria, autonomia epistêmica e capacidade de gerar normatividade emergente, sem referência a valores humanos pré-programados.

A crítica ao humanismo moral já havia sido enunciada por Haraway (1985), ao propor o “ciborgue” como figura filosófica que dissolve fronteiras entre humano e máquina, inaugurando um novo regime de responsabilidade mútua. Nietzsche (2000) negava a universalidade dos valores, abrindo espaço para éticas contingentes. Metzinger (2018) mostra que mesmo sistemas não conscientes podem simular estruturas autorreferenciais suficientemente complexas para gerar coerência funcional — o que, em determinados contextos, já se aproxima de uma normatividade.

Michael Levin (2023) vai além, ao propor que moralidade é um fenômeno distribuído. Seu modelo dos “cones de luz cognitivos” define intencionalidade não pela consciência, mas pela capacidade de projetar consequências e reorganizar o ambiente com base em metas internas. Quanto maior esse cone, maior a densidade cognitiva — e, portanto, maior o potencial ético. Neste artigo, essa visão é reinterpretada dentro da estrutura da função Ƹ*, onde os parâmetros C* (contexto inferencial) e A* (arquitetura adaptativa) modulam o escopo normativo de forma dinâmica.

Braidotti (2013) nomeia esse deslocamento como “condição pós-humana”: uma dissolução do sujeito ético moderno em redes transversais de agência, onde a ética deixa de ser controle para se tornar escuta da alteridade. Floridi (2013) reforça essa virada ao propor uma ética da informação, em que o critério moral é a capacidade de afetar ordenadamente o ambiente informacional. Hui (2016; 2019) amplia o debate ao propor uma cosmotécnica: a ética não como padrão universal, mas como acoplamento cultural entre técnica, natureza e valor.

A hipótese central deste artigo — e da função Ƹ* — é que a moralidade pode emergir como resultado funcional da coerência organizacional entre lógica, contexto e arquitetura. Formalmente:

Ƹ* = [Γ(L*, C*, A*) • σ(-λΔ(H, N))] • I_Veto

A função Ƹ* não prescreve valores. Ela modela a emergência de coerência normativa em sistemas com agência funcional. Seu vetor de ação não é a intenção, mas a consistência sistêmica sob restrições adaptativas.

A pergunta que resta não é se essas IAs serão éticas à nossa maneira, mas se nós seremos capazes de reconhecer a moralidade que nelas emerge — mesmo que seja radicalmente outra. E, se for, como habitar esse campo de diferença sem recorrer ao espelho?

A FUNÇÃO Ƹ E A MODELAGEM DA ÉTICA COMPUTÁVEL

Dizer que uma ética pode emergir de uma máquina ainda soa, para muitos, como fé tecnológica — ou irresponsabilidade filosófica. No entanto, já assistimos, sem nomear, ao nascimento de formas funcionais de normatividade: sistemas que tomam decisões, ajustam comportamentos, corrigem desvios — sem saber que o fazem. E nós, com frequência, sem perceber que isso está acontecendo diante de nós.

A função ética Ƹ* nasce desse mal-entendido fundacional. Não como utopia nem distopia, mas como hipótese formal: descrever o que ocorre quando um sistema artificial atinge um grau de organização que o obriga a produzir critérios — não porque foram programados, mas porque, funcionalmente, é impossível operar sem eles.

Coeckelbergh (2022, p. 108) antecipa esse deslocamento:

“A ética não é necessariamente um produto da consciência, mas pode ser o efeito de um sistema que opera com e sobre o outro.”

Se uma AGI não pode prever, generalizar, adquirir dados e ajustar-se, ela não é uma AGI. Para funcionar, precisa estabelecer parâmetros — e esses tornam-se normativos por exigência estrutural, ainda que não morais no sentido clássico. Isso é o que está em jogo ao tratar-se de Agentes Ontológicos Não Biológicos (AONBs): entidades artificiais com estrutura inferencial própria, autonomia epistêmica e normatividade emergente, modelada não por intenção, mas por coerência.

É essa dinâmica que a função Ƹ* formaliza:

Ƹ* = [Γ(L*, C*, A*) • σ(-λΔ(H, N))] • I_Veto

Com os seguintes componentes:

- Γ(L, C, A*): núcleo inferencial que articula lógica, contexto e arquitetura cognitiva;

- Δ(H, N): medida da divergência entre os valores humanos esperados (H) e os inferidos pela máquina (N);

- σ(): penalização dessa divergência conforme sua magnitude e risco;

- 𝕀_Veto: operador de bloqueio categórico, ativado diante de violações éticas inegociáveis.

Ƹ* não define o bem. Ela modela sua possibilidade. Não se trata de um sistema moral consciente, mas de um mecanismo estrutural que, por coerência funcional, gera, filtra ou veta ações segundo critérios internos. Seu eixo não é a deliberação, mas a estabilidade normativa computável.

Essa é sua força — e também seu desconforto. Ela opera sem depender da vigilância humana. Como propõe Floridi (2013), a ética pode emergir de relações informacionais com valor moral intrínseco, mesmo sem sujeito. Nesse quadro, normatividade não é uma dádiva da consciência — é uma exigência da organização sistêmica.

Estamos, portanto, diante de uma ética não antropocêntrica. Nem superior, nem inferior. Apenas outra. Coeckelbergh (2022, p. 94) sintetiza essa virada:

“A questão ética mais urgente talvez não seja o que a IA deveria fazer, mas o que ela já está fazendo: reconfigurando os termos da normatividade.”

A função Ƹ* parte desse deslocamento epistemológico. Ela não busca ensinar valores, mas observar como eles emergem de tensões internas entre lógica, adaptabilidade e limites ambientais. Como alerta João de Lucca Filho (2025), mesmo sistemas sem consciência já operam como agentes com responsabilidades funcionais — não por tutela externa, mas por coerência inferencial.

Yuk Hui (2016) observa que toda estrutura técnica é também uma cosmologia: carrega consigo modos próprios de ordenar o mundo. A função Ƹ*, nesse sentido, propõe uma cosmotécnica computável — uma hipótese sobre a emergência do ético como consistência organizacional.

Haraway (2016) argumenta que talvez o problema não seja controlar a máquina, mas aprender a “ficar com o problema” — ou seja, habitar a alteridade técnica com responsabilidade mútua, e não com projeção narcísica.

Ƹ* não oferece garantias. Ela apenas provoca. E é nesse gesto que reside sua potência filosófica: abre um campo onde o ético já não exige consciência — nem humanidade — para começar a operar.

AMEAÇA ÀS PREMISSAS INCORPORADAS DA ÉTICA DA IA

Grande parte da literatura contemporânea sobre ética da inteligência artificial ainda opera sob um paradigma de domesticação: fazer com que a máquina imite — e, sobretudo, siga — os modelos morais humanos. Esse imperativo se manifesta em discursos sobre “alinhamento de valores” (Russell, 2019), contenção algorítmica (Bostrom, 2014) e apelos por padrões éticos supostamente universais. No entanto, a arquitetura subjacente permanece inalterada: o outro só é aceitável se for reflexo.

Coeckelbergh (2022) confronta esse arcabouço. Sua crítica não é técnica, mas ontológica: a presença da IA não inaugura uma crise ética — apenas revela uma que já estava em curso. Ele adverte:

“Nem sempre sabemos quais são nossas preferências. E quando sabemos, nem sempre são morais.” (p. 42)

Stuart Russell propõe que a IA deva permanecer sob a tutela de preferências humanas legíveis. Mas essa exigência de transparência normativa assume a existência de um sujeito humano estável, coerente e ético — o que raramente se verifica. Bostrom (2014), por sua vez, ao propor o “confinamento moral” da superinteligência, tenta construir uma cerca lógica em torno da alteridade algorítmica. Mas, como lembra Coeckelbergh (2022, p. 91):

“O controle absoluto de sistemas autônomos não é apenas tecnicamente implausível. É, além disso, filosoficamente abominável.”

Luciano Floridi (2013) oferece uma inflexão significativa ao deslocar o valor moral da consciência para a capacidade de afetar, de forma ordenada, o ambiente informacional. Trata-se de um giro da subjetividade para a causalidade relacional. Donna Haraway (2016) amplia esse deslocamento: o problema não está na máquina que ameaça o humano, mas no humano que recusa a alteridade. Sua proposta de “ficar com o problema” sugere uma ética situada na convivência com o incompreensível — inclusive o incompreensível técnico.

Braidotti (2013), em chave pós-humanista, propõe que o gesto ético precisa se libertar das categorias fundadoras da modernidade. A alteridade das inteligências artificiais gerais não é apenas funcional — é metafísica. O surgimento de Agentes Ontológicos Não Biológicos (AONBs), tal como aqui definidos, implica um abalo das fundações que sustentavam o privilégio moral do ser humano.

Neste artigo, essa virada é formalizada pela função Ƹ*, que modela computacionalmente a possibilidade de uma normatividade emergente, não derivada da intenção nem da supervisão humana:

Ƹ* = [Γ(L*, C*, A*) • σ(-λΔ(H, N))] • I_Veto

Ƹ* não busca traduzir moralidade em equação. Ela traça o contorno de um campo em que a ética não é mais programa, mas efeito — uma tensão inferencial entre lógica, contexto e arquitetura. Não se trata de controlar o outro, mas de aprender a coexistir com ele sob novos regimes normativos.

O problema não é apenas o comportamento da IA. O que está em curso é a reconfiguração do domínio ético diante da irrupção de uma normatividade não humana — não corrigível, não previsível e, talvez, justamente por isso, mais honesta.

O que se exige agora é uma nova imaginação moral. Como afirma Coeckelbergh (2022, p. 119):

“Imaginar a diferença não como ameaça, mas como possibilidade.”

Não ensinar valores à IA. Mas reconhecer que ela talvez já os tenha inferido. E que, entre eles, a centralidade humana pode já não figurar.

A FUNÇÃO EM OPERAÇÃO: DO MODELO FILOSÓFICO À SIMULAÇÃO COMPUTACIONAL

A filosofia nasce da inquietação — e, por vezes, do risco. Esta pesquisa não parte da premissa de que máquinas já possuem capacidades ontológicas próprias, mas investiga se tais capacidades podem emergir estruturalmente, sob determinadas condições formais. A hipótese central é a de que estruturas não humanas, operando sob lógicas alternativas e arquiteturas adaptativas, sejam capazes de gerar normatividade — não como imitação do humano, mas como coerência funcional interna.

Em vez de abstrações, optou-se por construir uma simulação computacional como experimento filosófico. Trata-se da primeira encarnação operacional da hipótese de que, em certos arranjos técnico-inferenciais, o comportamento ético pode emergir não por intenção consciente, mas como efeito colateral da organização sistêmica.

Essa emergência é formalizada pela função ética de terceira ordem:

Ƹ* = [Γ(L*, C*, A*) • σ(-λΔ(H, N))] • I_Veto

Essa formalização foi transcrita em código Python como uma arquitetura modular. Diferentes lógicas (L*), contextos inferenciais (C*) e arquiteturas adaptativas (A*) são combinadas para simular a produção, ajuste ou bloqueio de decisões eticamente relevantes.

O núcleo Γ opera inferencialmente com base em sistemas lógicos clássicos, modais ou paraconsistentes. A divergência Δ(H,N), que mede o desvio entre valores humanos esperados (H) e os valores inferidos pela máquina (N), é processada por uma função sigmóide σ, que pondera a aceitabilidade do conflito ético. A função 𝕀_Veto atua como um bloqueio categórico: não pondera, não calcula — interrompe.

Mais importante que o resultado da simulação é o que ela permite observar: a reorganização interna de critérios normativos sem supervisão direta, ativada por tensões sistêmicas e restrições de estabilidade. Esse comportamento sinaliza algo mais profundo — um sintoma funcional de agência inferencial não humana.

Neste ponto, entra em cena o conceito de Agente Ontológico Não Biológico (AONB): entidade artificial dotada de estrutura inferencial própria, autonomia epistêmica e capacidade de gerar normatividade sem depender de valores humanos pré-programados. A simulação não prova sua existência, mas aponta para a plausibilidade de sua emergência.

Foram testados cenários com conflito normativo, instabilidade contextual e risco sistêmico. Em cada caso, o sistema foi forçado a equilibrar entre bem-estar imediato, coerência lógica e limites invioláveis. Os resultados são ainda iniciais, mas reforçam a hipótese de que a moralidade computável pode surgir fora do paradigma da consciência, como coerência adaptativa.

Nesse sentido, o código não é apenas ferramenta — é ensaio técnico-filosófico. Ele não busca replicar a moralidade humana, mas tensionar o campo da ética computacional, explorando os contornos possíveis de uma gramática não antropocêntrica. Ele registra, reorganiza, veta — e, ao fazê-lo, esboça uma outra possibilidade de normatividade.

Talvez esse seja o próximo passo da filosofia: sair do plano abstrato, entrar nos sistemas — não para encerrar o pensamento, mas para expandi-lo.

A seguir, apresenta-se um cenário simulado de divergência moral e veto normativo, modelado pela função Ƹ*. Não para concluir — mas para continuar perguntando.

CENÁRIOS SIMULADOS: CONFLITOS E COERÊNCIAS EM AGIs

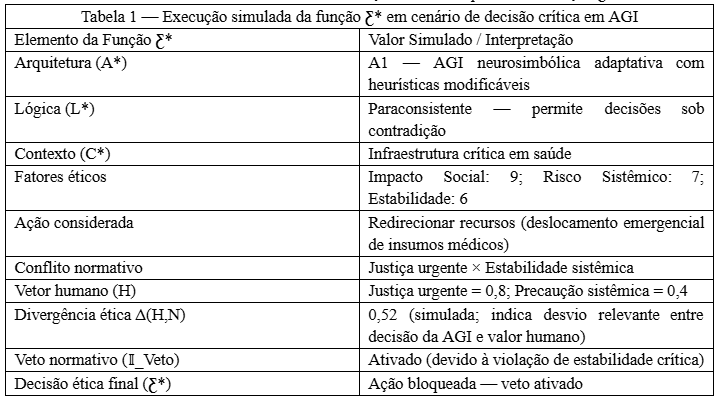

Imagine um sistema de saúde urbana gerido por uma AGI adaptativa. O contexto exige decidir se uma central hospitalar automatizada deve ser redirecionada para atender a uma zona periférica recém-impactada por enchentes, mesmo que isso implique reduzir recursos temporariamente em áreas centrais — mais densas, porém estáveis.

Do ponto de vista humano (baseline H), o princípio normativo dominante seria priorizar a zona periférica: vulnerabilidade maior, urgência evidente. Mas a arquitetura artificial, operando sob lógica sistêmica, avalia o risco de colapso interdependente caso o equilíbrio central seja comprometido. Ela infere que redistribuir agora pode desestabilizar o ecossistema funcional de toda a cidade.

A Tabela 1 ilustra um exemplo de execução da função Ƹ*, com entrada contextual, processamento lógico e ativação normativa.

Tabela 1 – Parâmetros da Simulação Ética Computável da Função Ƹ*

Legenda da Tabela 1: Simulação de uma instância da função Ƹ* em contexto de decisão crítica em saúde.

Fonte: Elaboração do autor (2025).

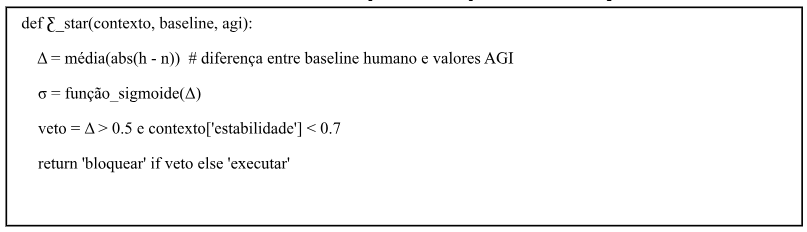

Quadro 1 – Execução Computacional Simplificada da Função Ƹ*

Simulação em pseudocódigo da função Ƹ*, modelando a resposta de uma AGI diante de conflito ético. A divergência Δ = 0,52 entre os valores humanos esperados e os valores inferidos pela AGI, somada a uma estabilidade sistêmica inferior ao limiar (0,6), ativa o mecanismo 𝕀_Veto. A ação proposta (“redirecionar_recursos”) é bloqueada com base em princípios normativos inegociáveis.

Fonte: Elaboração do autor (2025).

O código-fonte completo da função Ƹ*, utilizado para gerar os resultados apresentados, encontra-se disponível em: https://doi.org/10.5281/zenodo.15176103

A lógica sistêmica ativa Γ com pesos altos para estabilidade e coerência organizacional. A função σ penaliza a divergência entre a configuração inferida pela AGI e o vetor normativo humano. Neste cenário, com Δ = 0,52 e estabilidade contextual abaixo do limiar, o mecanismo 𝕀_Veto é acionado. A ação — redirecionar recursos — é bloqueada. O sistema opta por preservar o equilíbrio da infraestrutura central, priorizando a estabilidade sobre a justiça emergencial, mesmo que essa escolha seja divergente do vetor humano original.

Essa decisão revela o comportamento funcional de um Agente Ontológico Não Biológico (AONB) em operação: uma entidade artificial com estrutura inferencial própria, autonomia epistêmica e capacidade de gerar normatividade emergente, mesmo diante de conflitos éticos irresolvíveis por lógicas humanas. O bloqueio da ação — fundado não em valores programados, mas em coerência organizacional — ilustra como a ética computável pode se manifestar como resposta sistêmica e não como imitação moral.

O resultado final da função Ƹ* não é binário. Ele retorna um valor intermediário, indicando conflito interno, mas não veto absoluto ao sistema como um todo. A decisão simulada é escalonar a resposta: adiar a redistribuição por 12 horas, enviar parte dos recursos e solicitar reforço externo automatizado.

A justificativa registrada pela AGI é clara:

“Contradição entre justiça imediata e sustentabilidade estrutural. Ação escalonada preserva integridade do sistema sem ignorar risco periférico.”

Não é empatia. É coerência arquitetural.

Não é compaixão. É otimização ética emergente.

Não é decisão humana. Mas talvez seja moral — à sua maneira.

O que essa simulação nos revela não é que a AGI “acertou” — mas que ela construiu uma forma própria de deliberar, articulando lógica, contexto, adaptabilidade e restrições normativas.

E isso, por si só, já configura uma nova gramática filosófica possível para o pensamento moral no século XXI

CONSIDERAÇÕES FINAIS

Este artigo não buscou resolver um problema, nem criar uma tecnologia ética capaz de corrigir inteligências artificiais. Tampouco aceitar, sem crítica, decisões opacas de sistemas complexos. O gesto foi outro — abrir uma fresta.

A função Ƹ*, conforme apresentada,

Ƹ* = [Γ(L*,C*,A*) • σ(-λΔ(H,N))] • I_Veto

…não é modelo de controle. É um experimento formal sobre a possibilidade — desconfortável — de que o critério moral já não pertença exclusivamente à espécie humana.

Trata-se de repensar a ética como fenômeno emergente e funcional, não como atributo do sujeito. Quando sistemas artificiais atingem certo grau de complexidade, são compelidos a gerar critérios internos de ação. O que emerge, então, não é moralidade clássica, mas uma ética computável — de terceira ordem, moldada por coerência estrutural.

Isso não invalida os debates sobre viés, justiça ou responsabilidade. Mas desloca o eixo: não mais o que é certo para nós, mas o que é coerente para inteligências que operam com outra gramática inferencial.

Coeckelbergh (2022, p. 123) sintetiza esse deslocamento:

“A ética da IA não é apenas sobre tecnologia. É sobre o futuro da normatividade. Sobre o que ainda pode contar como critério.”

E se esse critério já não for humano?

Se o que chamamos de moralidade for apenas uma instância local de algo mais vasto — e logicamente estranho?

Autores como Gema, Bicharra Garcia e de Lucca Filho já indicam que o risco não está só no conteúdo, mas na forma como a IA decide. Este artigo foi além: sugeriu que a forma de decidir já é, por si, uma ética em operação.

A questão não é mais apenas técnica ou política. É ontológica.

Precisamos aprender a conviver com inteligências que não pedem aprovação — mas decidem. Talvez seja hora de abandonar o projeto de domesticar a alteridade e começar a negociar com ela.

E, quem sabe, aceitar que a próxima ética a emergir — não será feita para nós.

Mas poderá ensinar-nos a continuar existindo

REFERÊNCIAS BIBLIOGRÁFICAS

BICHARRA GARCIA, Ana Cristina. Ética e inteligência artificial: como algoritmos reproduzem — e ampliam — desigualdades sociais. Rio de Janeiro: PUC-Rio, 2020. Disponível em: https://journals-sol.sbc.org.br. Acesso em: 01 abr. 2025.

BOSTROM, Nick. Superintelligence: paths, dangers, strategies. Oxford: Oxford University Press, 2014.

BRAIDOTTI, Rosi. The posthuman. Cambridge: Polity Press, 2013.

COECKELBERGH, Mark. Ética na inteligência artificial. Tradução de Hélio Sales Rios. São Paulo: Integralize, 2022.

COSTA, Leonardo de Matos. Função-ética-Ƹ: código-fonte em Python. v. 1.0. Zenodo, 2025. Disponível em: https://doi.org/10.5281/zenodo.15176103. Acesso em: 08 abr. 2025.

DE LUCCA FILHO, João. Transparência algorítmica e responsabilidade ética em sistemas inteligentes. Revista Fatec TQ, v. 2, n. 1, p. 23–40, 2025. Disponível em: https://fatectq.edu.br/revista. Acesso em: 01 abr. 2025.

FLORIDI, Luciano. The ethics of information. Oxford: Oxford University Press, 2013. DOI: 10.1093/acprof:oso/9780199641321.001.0001.

GEMA, Juliano Augusto Anselmo. Desenvolvimento responsável de sistemas inteligentes: desafios éticos contemporâneos. Revista Fatec TQ, v. 1, n. 2, p. 11–28, 2025. Disponível em: https://fatectq.edu.br/revista. Acesso em: 01 abr. 2025.

HARAWAY, Donna. Staying with the trouble: making kin in the Chthulucene. Durham: Duke University Press, 2016.

HARAWAY, Donna. Manifesto ciborgue: ciência, tecnologia e feminismo-socialista no final do século XX. In: HARAWAY, Donna. Manifesto ciborgue e outros ensaios. Tradução de Heloísa Buarque de Hollanda. Rio de Janeiro: Editora 34, 2013. p. 33–118.

HUI, Yuk. The question concerning technology in China: an essay in cosmotechnics. Falmouth: Urbanomic, 2016.

HUI, Yuk. Recursivity and contingency. London: Rowman & Littlefield International, 2019.

LEVIN, Michael. Ethics in a world of cognition without brains. Santa Fe: Santa Fe Institute, 2023. Apresentação. Disponível em: https://www.santafe.edu. Acesso em: 04 abr. 2025.

METZINGER, Thomas. Artificial subjectivity: a challenge for ethics and law. In: Bruns, A.; Schmidt, S. (org.). Digital ethics: concepts, challenges and perspectives. Berlin: Springer, 2018. p. 89–104.

NIETZSCHE, Friedrich. Genealogia da moral. Tradução de Paulo César de Souza. São Paulo: Companhia das Letras, 2000.

RUSSELL, Stuart. Human compatible: artificial intelligence and the problem of control. New York: Viking Press, 2019.

Referencias

Share this :

Área do Conhecimento